#81(検証中)

マックスプーリングを持つネットワークに誤差を逆伝播する際には、”順伝播の際に選択した位置を覚えておき、その位置だけに誤差を逆伝播する”。

ほかのオプション:

- 順伝播の際に選択した位置だけでなく、全ての位置に誤差を逆伝播する。

- 順伝播の際に選択した位置を覚えておき、その位置だけに一定の値を逆伝播する。

- 順伝播の際に選択した位置だけでなく、全ての位置に一定の値を逆伝播する。

#82

ニューラルネットワークで構成するディープラーニングにおけるマックスプーリングの特徴として”適用したカーネル内のピクセル値の最大値を代表値として出力する”点がある。

#83

畳み込みニューラルネットワーク(CNN)等で実行されるプーリング手法の中に、マックスプーリングと平均値プーリングがある。同じ大きさの行列に対して適用される、マックスプーリングと平均値プーリングのウィンドウサイズとストライド幅がそれぞれ同じである場合に、この2つのプーリングにおいて、”出力結果のサイズはどちらも同じである”。

#84

勾配消失問題、勾配爆発問題に関する説明

- 勾配爆発があると学習が安定

するしない。 - 勾配消失があるとコスト関数を改善するためにパラメータをどの方向に動かすべきかを知ることが難しくなる。

- 勾配爆発問題には勾配クリッピングが有効である。

- 勾配消失問題はスキップ接続を導入することによって軽減できる。

#85

転移学習とファインチューニングにおける説明

- 転移学習とは、ある特定の問題を解くために獲得した知識を、異なるが関連はある問題に適用する機械学習の一般的方法である。

- コンピュータによる画像中の物体認識の精度を競う国際コンテストImageNet(ILSVRC)のカテゴリー認識のタスクを学習した畳み込みニューラルネットワーク(CNN)は、転移学習に向いていて、ILSVRC向けに学習済みのAlexNetやVGGNetをポーズ推定などのタスクに流用できる。

- 転移学習の最も簡単な方法は、学習済みのCNNをそのまま使い、目的の画像をそのCNNに入力して得られる中間層の出力をその画像から抽出した「特徴」とみなす方法である。こうして取り出した特徴は、例えばサポートベクトルマシンなどの適当な分類器に入力し目的とする分類を行う。

- ファインチューニングは、目的タスクの学習サンプルを用いて学習済みのCNNの

下位層上位層(後半部)だけを目的タスク用に設計しなおし、上位層下位層(前半部)は重みを含めてそのままとしておき、これを新たなタスクについて再学習する。

#86

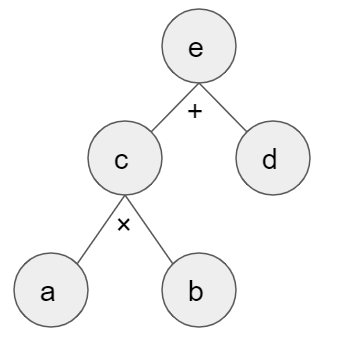

下記の計算グラフについて、a = 2, b = 1, e = 5が与えられたとき、dの値は”3”となる。

#87

計算グラフ中のあるノードは、上流から入力値を受け取ると、入力値を二乗した値を下流に出力する。このグラフを逆伝播すると、下流から受け取った値を”2”倍して上流に渡す。

#88

ニューラルネットワークで多クラス分類を行うとき、出力層に用いる活性化関数として”ソフトマックス関数”が挙げられる。

#89

畳み込みニューラルネットワーク(CNN)を提案された順に並べると”LeNet > AlexNet > GoogLeNet > ResNet”となる。

#90

学習を進めたときに途中から検証データのコスト関数の値のみが高いままになった状態が過学習と呼ばれる。

コメント